论文: Xie S, Girshick R, Dollár P, et al. Aggregated Residual Transformations for Deep Neural Networks[J]. 2016.

论文概述

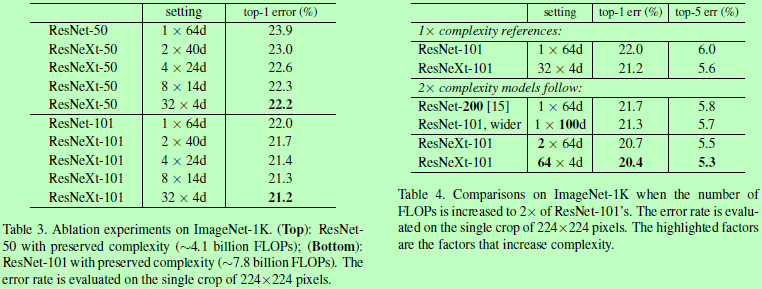

在ResNet的基础上改进得到的ResNeXt,性能比ResNet好(101层的ResNeXt比200层的ResNet准确率高,且复杂度少一半),且只有少量的超参数需要设置。提出了一个cardinality(the size of the set of transformations)的概念,认为变换函数集合的规模大小是除了网络深度和宽度外对网络性能提高的一个关键因素。在ImageNet分类任务中,作者实验表明在维持网络复杂度的情况下,增加cardinality可以提高分类准确率。并且增加cardinality比增加网络深度或宽度更容易提升网络性能。

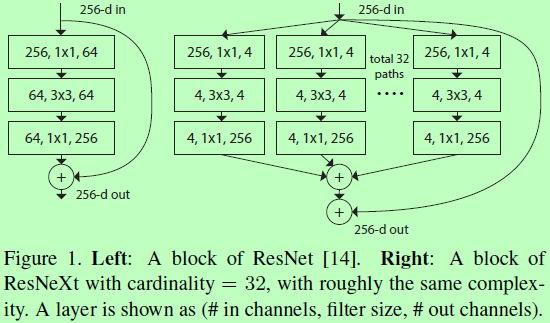

该结构的搭建使用了VGG和ResNet中反复堆叠层和split-transform-merge的策略,如下图1所示。其中右边的网络内有多条通路分支,每个分支数量就是cardinality。且每个分支结构相同,使得分支数量是唯一需要关注的参数,可以随意扩展而不需要特殊的设置,减轻设计负担。

Aggregated Transformations

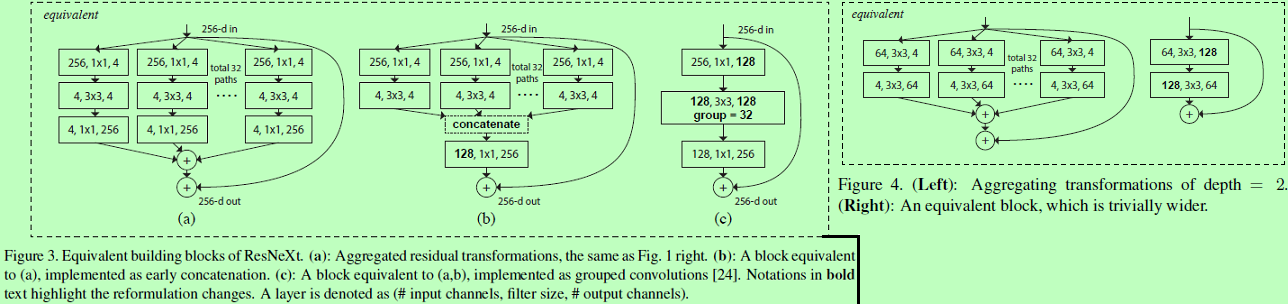

下图3是相对于Inception-ResNet和Grouped Convolutions的等价模型。图4是对于当block的深度只有2时的情况及其等价模型。

Model Capacity

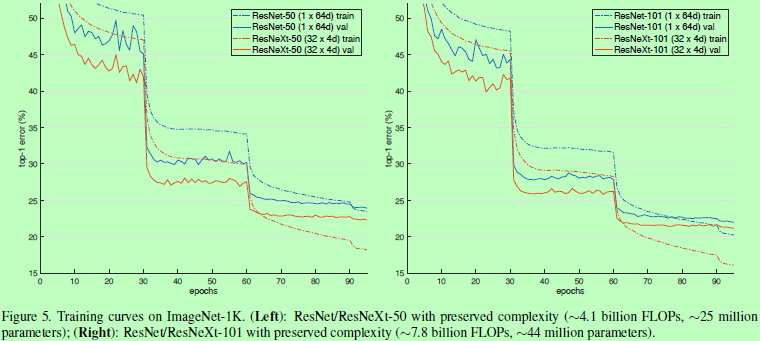

Experiments

其中cardinality = 32,bottleneck width(通道数)= 4d时,表示为32 x 4d。